Mo–Fr: 09:00–17:00 Sa–So: geschlossen

03578 310535 info@formality.de

FORMALITY Deutschland 01917 Kamenz

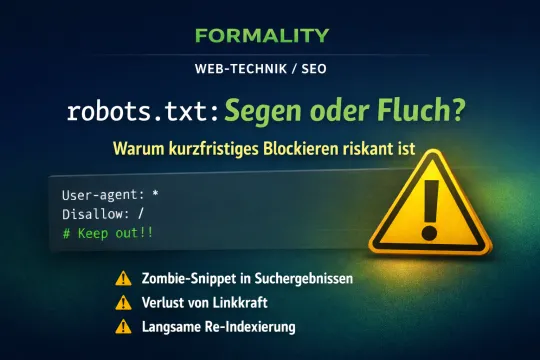

robots.txt: Segen oder Fluch? Warum kurzfristiges Blockieren riskant ist

Die robots.txt ist eine der mächtigsten kleinen Dateien in Ihrem Webhosting-Verzeichnis. Sie sagt dem Googlebot und anderen Suchmaschinen, welche Bereiche Ihrer Webseite sie besuchen dürfen – und welche nicht. Doch was wie ein schneller „Aus-Schalter“ für unfertige Seiten wirkt, entpuppt sich oft als Bumerang für das Google-Ranking.

Wann ist ein Blockieren sinnvoll?

Es gibt legitime Gründe, Verzeichnisse vor Crawlern zu verbergen:

- Interne Bereiche: Admin-Logins (z.B.

/wp-admin/oder cPanel-Verzeichnisse). - Skripte & Ressourcen: Systemordner, die keine für Nutzer relevanten Inhalte enthalten.

- Entwicklungsumgebungen: Wenn Sie unter einer Subdomain eine neue Seite testen.

Der Gedanke „Ich nehme die Seite mal kurz über die robots.txt raus, bis sie fertig ist“ ist jedoch oft ein technischer Trugschluss.

Die Probleme beim kurzfristigen Blockieren

Wenn Sie eine bereits indexierte Seite plötzlich via Disallow sperren, passieren im Hintergrund drei Dinge, die später schwer zu korrigieren sind:

1. Das "Zombie-Snippet"

Entgegen der verbreiteten Meinung löscht ein Disallow in der robots.txt die Seite nicht sofort aus dem Index. Google weiß weiterhin, dass die URL existiert, darf sie aber nicht mehr besuchen. Das Ergebnis: In den Suchergebnissen erscheint Ihre Seite ohne Beschreibung mit dem Hinweis: "Informationen zu dieser Seite sind aufgrund der robots.txt nicht verfügbar." Das wirkt unprofessionell und senkt die Klickrate massiv.

2. Verlust von Linkkraft (Link Equity)

Wenn die gesperrte Seite Backlinks von anderen Webseiten hat, kann Google diese durch die Sperre nicht mehr verfolgen. Die wertvolle "Link-Autorität" versickert im Nichts und stärkt nicht mehr Ihre gesamte Domain.

3. Die Indexierungs-Verzögerung bei Freigabe

Hier liegt das größte Problem: Wenn Sie das Verzeichnis nach Wochen wieder freigeben, hat Google die Seite auf eine "niedrige Priorität" gesetzt. Es kann Tage, Wochen oder sogar Monate dauern, bis der Bot die Seite wieder im alten Rhythmus besucht und die Rankings wiederhergestellt sind.

Bessere Alternativen zum Blockieren

Wenn Sie verhindern wollen, dass Inhalte in der Suche erscheinen, nutzen Sie statt der robots.txt lieber diese Methoden:

| Methode | Wirkung | Einsatzbereich |

|---|---|---|

| Meta-Tag "noindex" | Die Seite wird gecrawlt, aber sicher aus dem Index entfernt. | Beste Wahl für kurzfristige Änderungen. |

| Passwortschutz (cPanel) | Weder Mensch noch Bot kommen ohne Login auf die Seite. | Ideal für Baustellen & Testumgebungen. |

| HTTP 410 (Gone) | Signalisiert Google, dass die Seite dauerhaft gelöscht ist. | Für Inhalte, die nie wieder kommen sollen. |

Strategischer Leitfaden: Re-Indexierung nach einer robots.txt-Sperre

Wenn eine Seite längere Zeit per robots.txt gesperrt war, "verlernt" Google die Struktur Ihrer Webseite. Werden die Barrieren einfach nur entfernt, dauert es oft Wochen, bis der Crawler alle Ebenen wiederfindet. Um diesen Prozess zu beschleunigen, sollten Sie nach dem Top-Down-Prinzip (von oben nach unten) vorgehen.

Die Strategie: Von der Wurzel in die Zweige

Reichen Sie nicht jede Unterseite einzeln ein. Das ist ineffizient und führt oft zu einer Limitierung durch Google. Das Ziel ist es, Google zu zeigen, dass die "Eingangstür" wieder offen ist und von dort aus ein klarer Weg in die Tiefe führt.

Schritt 1: Die technische Barriere entfernen

Bevor Google irgendetwas tun kann, muss die Erlaubnis technisch erteilt werden:

- Öffnen Sie die

robots.txtDatei im Hauptverzeichnis Ihrer Domain - Entfernen Sie die entsprechenden

Disallow-Zeilen für das Verzeichnis oder die Domain. - Wichtig: Prüfen Sie mit dem "robots.txt-Tester" in der Google Search Console, ob der Zugriff für den Googlebot nun auf "Erlaubt" steht.

Schritt 2: Die "Eingangstür" öffnen (Domain-Ebene)

Gehen Sie in die Google Search Console und nutzen Sie das URL-Prüftool:

- Geben Sie die URL der Startseite (oder des Hauptverzeichnisses) ein.

- Klicken Sie auf "Indexierung beantragen".

Warum zuerst oben? Google erkennt so sofort, dass die oberste Hierarchieebene wieder zugänglich ist und wird die darin enthaltenen internen Links automatisch priorisiert verfolgen.

Schritt 3: Die Landkarte aktualisieren (Sitemap-Ebene)

Dies ist der wichtigste Schritt, um die Tiefe der Seite schnell zu erfassen:

- Erstellen Sie eine frische

sitemap.xml(z. B. über das WP-Toolkit oder ein SEO-Plugin). - Stellen Sie sicher, dass alle zuvor gesperrten Unterseiten in der Sitemap enthalten sind.

- Laden Sie die Sitemap im cPanel hoch und reichen Sie die URL in der Search Console unter dem Menüpunkt "Sitemaps" neu ein.

Dadurch erhält Google eine vollständige Liste aller "tiefen" URLs, ohne mühsam von Link zu Link springen zu müssen.

Zusammenfassung der Reihenfolge

| Priorität | Aktion | Ziel |

|---|---|---|

| 1. Höchste | robots.txt bereinigen | Zugriff technisch erlauben. |

| 2. Hoch | Haupt-URL einreichen | Crawler zur Startseite locken. |

| 3. Mittel | Sitemap neu einreichen | Alle Unterseiten auf einmal anmelden. |

| 4. Begleitend | Interne Links setzen | Den Crawler von starken Seiten in neue Bereiche leiten. |

Häufige Fehler vermeiden

Versuchen Sie nicht, hunderte Unterseiten manuell via URL-Prüftool einzureichen. Google begrenzt dieses Kontingent pro Tag. Vertrauen Sie stattdessen auf eine saubere Sitemap und eine gute interne Verlinkung von Ihrer Startseite aus.

Stellen Sie zudem sicher, dass nach dem Entfernen der robots.txt-Sperre nicht versehentlich noch ein noindex-Meta-Tag im Header Ihrer HTML-Dateien verblieben ist, da dies die Indexierung erneut stoppen würde.

Tipp von FORMALITY: Nutzen Sie die cPanel-Metriken, um zu beobachten, wann der Googlebot nach Ihren Änderungen das erste Mal wieder in das zuvor gesperrte Verzeichnis zugreift.

Fazit für Admins

Nutzen Sie die robots.txt nur für Dinge, die dauerhaft unsichtbar bleiben sollen. Für alles andere ist der Passwortschutz im cPanel oder das Noindex-Tag die sicherere Wahl. So verhindern Sie, dass Ihr Google-Ranking nach einem Umbau im Keller landet.

Tipp von FORMALITY: Überprüfen Sie Ihre robots.txt regelmäßig in der Google Search Console, um sicherzustellen, dass Sie nicht versehentlich wichtige CSS- oder JS-Dateien blockieren, die Google für die mobile Darstellung benötigt!